Dec 29 2025

【2025年】NotebookLMが大幅に進化!使わないと勿体ないツールに

年の瀬ということで、皆さんはいかがお過ごしでしょうか?

せっかくの年末なので、今回は「2025年で個人的に最も進化を感じた生成AIツール」をご紹介していきたいと思います。

それが、「NotebookLM」です。

NotebookLM自体は2023年から登場したツールなんです。

ただし、当初は研究者・学生向けのツールとしての意味合いが強く、ビジネスでの活用はあまりイメージができませんでした。

それが2025年で怒涛の進化を遂げたわけです。

個人的にビジネスユースでオススメしたい生成AIツールの上位に食い込んできました。

今回は、実際2025年のNotebookLMの進化の軌跡をまとめていきます。

🕐 2025年、NotebookLMは何が変わったのか?

まず全体像を見ていきましょう。

2025年のNotebookLMは、月を追うごとに新機能が追加されていきました[1]。

特に注目すべきは、5月のモバイルアプリリリースと、11月から12月にかけての怒涛のアップデートです。

【時系列で見る2025年NotebookLMアップデート】

| 時期 | 主要アップデート | 概要 |

|---|---|---|

| 4月29日 | Audio Overview 50言語対応 | 多言語でのポッドキャスト風音声生成が可能に[2] |

| 5月19日 | モバイルアプリリリース | iOS/Androidで外出先から利用可能に[3][4] |

| 7月29日 | Video Overviews登場 | ナレーション付きスライド形式の動画要約機能[5] |

| Studioパネル刷新 | 複数の出力形式を同時に作成可能に[5] | |

| 9月8日 | フラッシュカード&クイズ機能 | 学習教材の自動生成が可能に[6] |

| Audio Overviewに新形式追加 | Debate形式など多様な視点での音声生成[6] | |

| 10月13日 | Nano Banana統合 | Video Overviewsに6つの新スタイル追加[7] |

| 11月13日 | Deep Research機能搭載 | AIが自動的にWeb検索して詳細レポート作成[8] |

| Googleスプレッドシート連携 | データを直接インポート可能に[8] | |

| Microsoft Word対応 | PDFに変換せずそのまま取り込み可能[8] | |

| 画像ファイル対応 | 画像を直接ソースとして利用可能に[8] | |

| 12月16日 | スライド・インフォグラフィック自動生成 | Nano Banana Proによる高品質ビジュアル作成[9] |

| 12月18日 | データテーブル機能 | PDFから表を自動抽出しGoogle Sheetsへ出力[10] |

この表を見ると、2025年のNotebookLMが「学習ツール」から「総合的なビジネスツール」へと急速に進化したことがわかりますね。

⭐ 個人的に「これは使える!」と思った機能

正直、すべての機能が素晴らしいのですが、その中でも特に「ビジネスで使える」と感じた機能をご紹介します。

🎯 第1位:スライド&インフォグラフィック自動生成

これは、本当に衝撃的でした。

何が変わったのか?

アップロードした資料から、プレゼン資料や理解を進めてくれる図解資料を自動生成してくれるようになりました。

2025年で同じく話題になった「Nano Banana Pro」という画像生成AIが搭載され、洗練されたビジュアルを作成してくれます[9]。

なぜ良かったのか?

まず、「要約・理解をグラフィック化」してくれる点が素晴らしいわけです。

デザイン知識がなくても「それっぽい」プレゼン資料ができてしまいます。

例えば、研究ノートやブレインストーミングの内容を、カスタマイズされたスライドデッキに変換できるんですね。

つまり、「ビジュアルコミュニケーションの敷居が一気に下がった」と言えます。

従来は、以下のような流れでした。

- 資料を読み込む

- PowerPointを立ち上げる

- スライドのレイアウトを考える

- テキストを入力する

- 画像やグラフを挿入する

- デザインを調整する

これが、NotebookLMでは「資料をアップロード → 自動生成 → ダウンロード」の3ステップで完了するわけです。

これは、時間のない営業担当者や企画職の方には、まさに救世主と言えるでしょう。

🔮 将来性を感じる2つのアップデート

それでは次に「今は地味だけど、将来すごいことになりそう」と感じたアップデートを2つご紹介します。

① Googleスプレッドシート連携(11月13日)

何が注目なのか?

これまでは、スプレッドシートをPDF化してからNotebookLMに投入する必要がありました。

それが、「スプレッドシート → そのまま連携」できるようになったんですね。

つまり、データを「読む」から「データそのものをソース」にする発想の転換です。

将来、どうなるのか?

Googleスプレッドシートのデータが即座にAI分析の対象になります。

これは、SalesforceやTableauなどのBIツール連携へ向かう第一歩と言えるでしょう。

ビジネスデータとAI分析の距離がほぼゼロになるわけです。

② データテーブル機能(12月18日)

何が注目なのか?

PDFやドキュメント内の表を自動認識して抽出し、Google Sheetsに出力してくれます。

つまり、「情報の『読み取り』」と「『構造化』」が一つのフローに統合されたんですね。

NotebookLMが自動的に関連情報を整理し、表形式で提示してくれるため、手作業でのコピー&ペーストが不要になりました。

将来、どうなるのか?

これにより、「スプレッドシート → AIで分析 → テーブル出力」という完全なデータ循環が完成します。

Excel・Looker・BI連携への扉が開くわけです。

「NotebookLM = データパイプライン」としての立場が確立される可能性があります。

💡 この2つの組み合わせが面白い理由

では、なぜこの2つが重要なのか?

答えはシンプルです。

「スプレッドシート連携」+「データテーブル出力」= AIの「入出力」両端がデータベース化される

つまり、単なる「チャットツール」から「データ → AI分析 → データ」のパイプラインへの進化なんですね。

NotebookLMが単なる情報参照ツールではなく、「データドリブンなビジネスプロセスの中核」になる可能性が見えてきます。

これは、DX推進を担当されている皆さまにとって、非常に大きな意味を持つと思います。

📊 まとめ:2025年NotebookLMの進化の核心

2025年は、NotebookLMが「学習支援ツール」から「ビジネスの実務を変えるツール」へと大きく進化した年でした。

特に後半の11月〜12月にかけて、Deep Research、スプレッドシート連携、スライド自動生成、データテーブル機能といった、仕事の時間を奪う機能が立て続けに登場したわけです。

そして、それらが単なる「便利機能」ではなく、「データパイプライン」という、より大きなビジョンの一部として機能し始めている点が重要なんですね。

NotebookLMは、もはや単なるノートツールではありません。

情報をインプットし、AIが分析・加工し、ビジネスに使える形でアウトプットする

この一連の流れを、すべて1つのツールで完結できるようになりつつあるわけです。

2023年に登場した当初、「学生・研究者向けのノートツール」だったNotebookLMが、2025年を経て「ビジネスの現場で使える本格的な生成AIツール」へと進化しました。

もし皆さんが、まだNotebookLMを使ったことがないのであれば、ぜひ一度試していただきたいと思います。

きっと、「なぜもっと早く使わなかったんだろう」と感じるはずです。

それでは、良い年末をお過ごしください。

最終更新日:2025年12月29日

※免責事項

本記事の情報は執筆時点のものです。AI技術は急速に進歩しているため、最新情報については各サービスの公式サイトをご確認ください。

Citations :

- Google公式ブログ:2025年AI発表まとめ

- Google公式ブログ:Audio Overview 50言語対応

- Google公式ブログ:NotebookLMモバイルアプリ発表

- Google公式ブログ:Google I/O 2025発表まとめ

- Google公式ブログ:Video Overviews & Studio刷新

- Google公式ブログ:学習機能アップデート

- Google公式ブログ:Nano Banana統合

- Google公式ブログ:Deep Research & ファイル形式拡張

- Google公式ブログ:スライドデッキ機能

- Google Workspace Updates:データテーブル機能

Previous Post

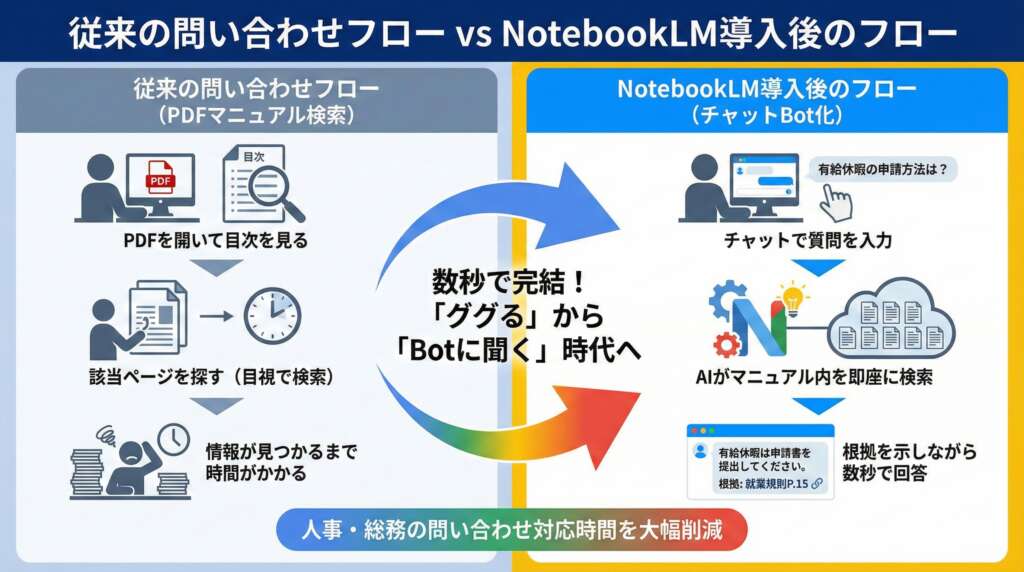

【NotebookLM活用事例】社内マニュアル:チャットBot化で人事・総務の問い合わせを削減する方法

Next Post

【今後に注目!】強力な学習向けツール「Learn Your Way」の使い方解説

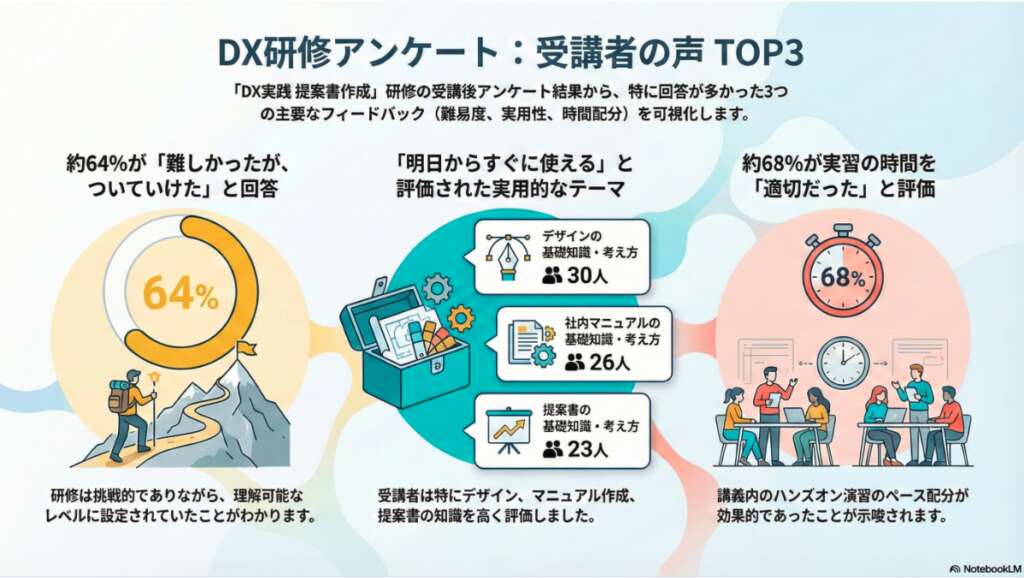

生成AI・IT活用の初心者向け解説を得意とするWebライター。

商品開発や業務効率化のコンサルタントとして10年以上の活動を行い、現在は中小企業のデジタル活用支援や、AIツールの導入・教育コンテンツ制作を多数手がける。DX研修の受講者数は100名を優に超える。

「難しい技術を、やさしく・わかりやすく」をモットーに情報発信中。